Maggio e Giugno sono i mesi in cui sono concentrati gli eventi pubblici principali delle grandi aziende collegate all’IT. Alcune aziende come Apple si concentrano maggiormente sugli aggiornamenti dei prodotti legati ai loro dispositivi (sistema operativo e apps), altre come Microsoft e Amazon presentano le novità relative ai propri cloud (Azure e AWS). Google, infine, fa entrambe le cose: vengono presentate sia le novità di Android che i nuovi servizi cloud. Tutti gli eventi di quest’anno hanno dato ampio risalto all’AI e al Machine Learning: c’è una forte concorrenza e ognuno ha presentato risultati fantastici in campi come l’analisi delle immagini, la comprensione dei testi o il Natural Language Processing (di cui ci ha parlato Salvatore Merone qui). Proviamo quindi a dare un’occhiata a quanto è stato presentato nelle ultime settimane in questi eventi.

Google/ IO 2021

LaMDA (Language Model for Dialog Applications)

Il Natural Language Processing negli ultimi anni ha tratto enorme giovamento dalla ricerca condotta da Google. LaMDA è il nuovo modello basato su Transformer, una rete neurale resa open source da Google Research nel 2017. Siamo di fronte a un motore di dialogo in grado di condurre una conversazione libera su un numero molto grande di argomenti, mostrando la capacità di seguire il suo interlocutore in maniera del tutto naturale, a differenza dei suoi predecessori.

Nella demo mostrata all’evento, LaMDA ha condotto una conversazione impersonando il pianeta Plutone e poi un aeroplanino di carta!

Google Maps

Sono state introdotte due novità nel prodotto storico di Google, entrambe basate sull’AI: il calcolo dei percorsi più efficienti dal punto di vista del consumo del carburante e Safer Routing. Quest’ultima funzionalità permetterà di seguire il percorso più sicuro per arrivare a una destinazione considerando le condizioni meteo e il traffico.

Rivelazione di problemi dermatologici

Dopo aver contribuito alla ricerca sul cancro al seno e alla retinopatia diabetica, Google ha presentato uno strumento che, partendo dalle foto scattate da un telefono, è in grado di scoprire problemi dermatologici.

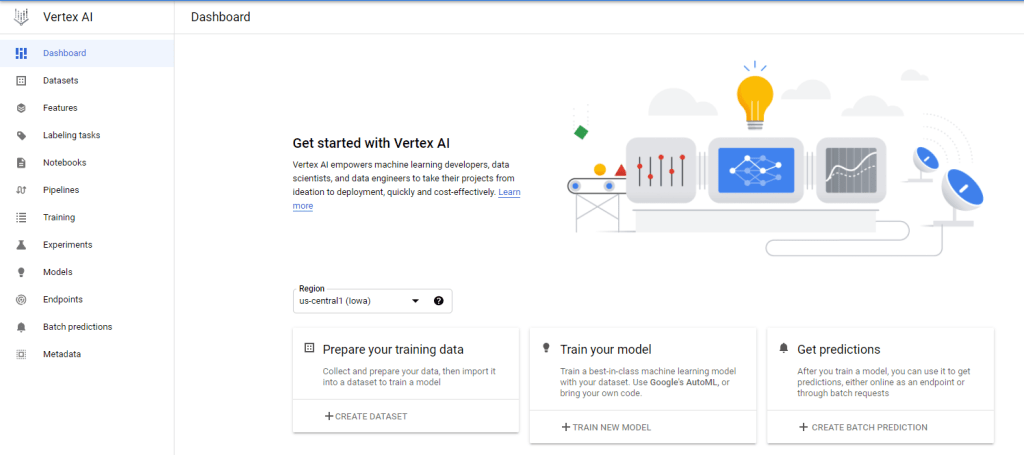

Vertex AI: la nuova piattaforma cloud di AI

Vertex AI è la nuova piattaforma di machine learning cloud di Google che unisce AutoML e AI Platform in una nuova API, libreria client e interfaccia utente. Lo scopo è permettere di creare e distribuire più velocemente modelli di ML. Sono stati introdotti anche degli strumenti di codifica avanzata che riducono dell’80% la quantità di codice scritto.

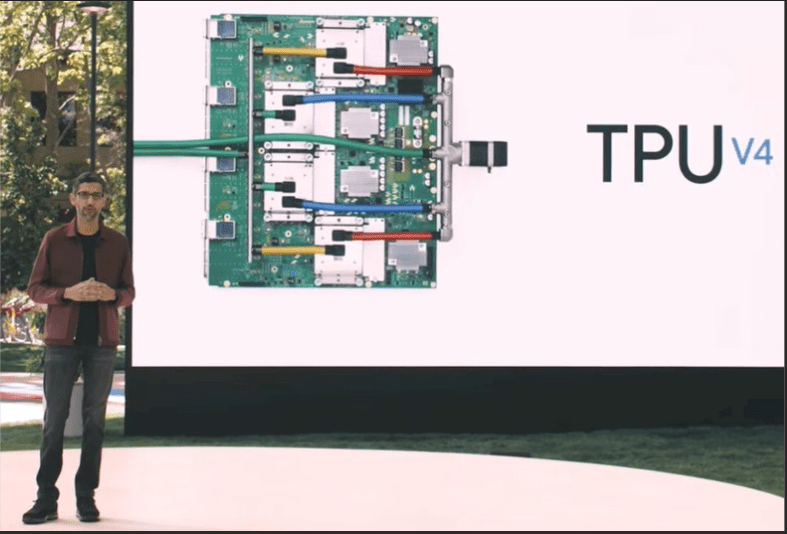

TPU di nuova generazione

Google ha presentato le tensor processing units (TPU) di quarta generazione. Una TPU è una classe di microprocessori progettati per fornire accelerazione hardware a reti neurali, classificatori di immagini, natural language processing e modelli per traduzioni. I cluster TPUv4, detti anche pods, sono costituiti da 4096 chip interconnessi in grado di offrire più di un exaflop di potenza di calcolo, equivalenti a 10 milioni di laptop di media potenza. I TPUv4 saranno a breve disponibili nei datacenter cloud di Google.

MUM: la nuova generazione di algoritmi AI

MUM (Multitask Unified Model) è un nuovo algoritmo di AI, 1000 volte più potente dei suoi predecessori basati sul’architettura Transformer. Sarà utilizzato per rendere ancora più efficiente il motore di ricerca: ossia potremo porre domande più specifiche ricevendo risposte molto più dettagliate. MUM non solo è in grado di comprendere il linguaggio ma è anche in grado di generarlo in 75 differenti lingue.

Tensorflow Lite

TensorFlow è una piattaforma open source end-to-end per il machine learning. Ha un ecosistema completo e flessibile di strumenti, biblioteche e risorse della comunità che consente ai ricercatori di spingere lo stato dell’arte nel ML e agli sviluppatori di creare e distribuire facilmente applicazioni basate sul ML. La versione Lite consente di eseguire i modelli di machine learning su dispositivi mobile Android, iOS e IoT. La novità più importante, però, è che gli stessi modelli generati per i dispositivi mobile ora potranno essere eseguiti anche nei browser per la classificazione delle immagini, rilevamento di oggetti e altri task comuni grazie allo standard WebAssembly.

Microsoft Build 2021

Il 25 maggio alle ore 18:00 CEST, Satya Nadella, CEO di Microsoft, ha dato il via a Build 2021, la conferenza annuale dedicata agli sviluppatori, con un keynote virtuale durante il quale ha delineato la strategia di Microsoft per aiutare gli sviluppatori a creare il futuro. E’ possibile rivederlo a questo link. Ampio spazio è stato dedicato alle soluzioni per gli sviluppatori per favorire collaborazione e produttività: ad esempio le nuove integrazioni per Power Platform e Visual Studio, gli ultimi investimenti su Java e la applicazioni di livello enterprise nel cloud Azure. Sono state mostrate le nuove funzionalità di Teams per migliorare quello che viene definito lavoro ibrido: ossia la possibilità di lavorare ovunque, a qualsiasi ora e su qualsiasi device. Per quanto riguarda la AI, Microsoft ha cercato di risolvere la confusione che regnava tra i consumatori dei servizi di intelligenza artificiale introducendo gli Azure Applied AI Services.

Azure Applied AI services

L’idea base è portare in produzione soluzioni di AI in giorni invece che in mesi: generare quindi valore velocemente con servizi specializzati nei processi business più comuni. A quelli che erano i Cognitive Services già esistenti sono stati aggiunti modelli per risolvere problemi specifici dando poi l’opportunità di estenderli con il servizio di Machine Learning di Azure

La lista completa dei servizi offerti è la seguente:

- Azure Bot Service: per creare bots e connetterli a dei canali di comunicazione. Siamo quindi nella macro area delle conversazioni.

- Azure Form Recognizer: trasformare documenti in dati utili in pochissimo tempo. La macro area è quella dei documenti

- Azure Cognitive Search: portare i servizi di ricerca cloud nelle applicazioni web e mobile. La macro area è quella della ricerca.

- Azure Video Analyzer: estrarre informazioni utili dai vostri video. La macro area è quella dei video.

- Azure Immersive Reader: aiutare i lettori a leggere e comprendere un testo. La macro area è quella dell’accessibilità

- Azure Metric Advisor: monitorare in maniera pro attiva i dati provenienti da ogni possibile sorgente per diagnosticare e prevenire problemi. Siamo nell’area del monitoraggio

PyTorch Enterprise su Azure

PyTorch è un framework di deep learning open-source di grande successo usato da Microsoft in prodotti come Bing e gli Azure Cognitive Service. In collaborazione con Facebook, è stato annunciata una nuova iniziativa chiamata PyTorch Enterprise Support Program per abilitare i fornitori di servizi a offrire una verticalizzazione enterprise ai loro clienti. A tale scopo, Microsoft ha lanciato PyTorch Enterprise su Azure per integrare PyTorch con soluzioni pubblicate su Azure.

Power Apps

Microsoft ha presentato gli ultimi aggiornamenti al proprio linguaggio low code open source Power Fx, che permette a tutti di creare app utilizzando il linguaggio naturale facendo leva su GPT-3, il potente modello di linguaggio naturale sviluppato da OpenAI che verrà integrato all’interno di Power Apps, la piattaforma di sviluppo low code di Microsoft

Apple WWDC 2021

Nella keynote virtuale di WWDC, tenuta il 7 Giugno, sono state annunciate numerose novità relative ai sistemi operativi in esecuzione su iPhone, iPad e MacBook. Molto spesso è stato usato il termine On-Device intelligence per indicare che gran parte delle operazioni di AI verranno svolte localmente sui dispositivi grazie all’Apple Neural Engine. Allo scopo di proteggere la privacy degli utenti, l’assistente Siri processerà quanti più dati possibili (non è stata indicata però una percentuale) in locale: ad esempio l’audio da analizzare nella speech recognition non lascerà mai il dispositivo risolvendo il dubbio che la Apple possa tenere conservate registrazioni dei nostri audio. A parte la privacy, sarà possibile quindi interagire più velocemente con Siri perché molte richieste non avranno bisogno di una connessione internet: lanciare app, cambiare impostazioni, controllare la musica, aggiungere una nota, etc. L’app LiveText userà anch’essa l’AI on device per riconoscere il testo in una foto (ed eventualmente tradurlo): sarà possibile ad esempio catturare un numero telefonico da un’insegna con la camera e lanciare direttamente la chiamata. Spotlight, altra nuova app, sarà in grado di cercare nelle nostre foto località persone, scene ed oggetti.

AWS Machine Learning Summit

La keynote virtuale dell’evento organizzato da Amazon, è iniziata ricordando come il machine learning sia ormai mainstream e come oltre 100000 clienti usino AWS per il machine Learning (ad esempio il New York Times o giganti farmaceutici come Roche). All’evento (potete registrarvi qui per accedere al video) sono stati presentati numerosi casi di successo di utilizzo di SageMaker, la piattaforma dedicata agli sviluppatori e ai data scientist per preparare, creare, addestrare e distribuire rapidamente modelli di alta qualità. SageMaker sta evolvendo lungo tre direzioni: infrastruttura, strumenti e industrializzazione del ML.

E’ stato citato AWS Inferentia, il primo chip di silicio personalizzato progettato per accelerare i carichi di lavoro di deep learning Il kit di sviluppo software (SDK) AWS Neuron è composto da strumenti compiler, runtime e di profilazione che aiutano a ottimizzare le prestazioni dei flussi di lavoro per AWS Inferentia. Gli sviluppatori possono distribuire modelli complessi di reti neurali, costruiti e allenati su framework popolari come Tensorflow, PyTorch, e MXNet, possono inoltre distribuirli sulle istanze Amazon EC2 Inf1 basate su AWS Inferentia. Ma entro fine anno saranno disponibili sulle istanza Amazon EC2 nuovi chip, come Trainium.

Ogni persona che lavori per Amazon deve imparare il machine learning. E’ stato quindi presentato anche un MOOC (massively open online course) su Coursera dedicato interamente al deep learning chiamato Pratical Data Science.

Conclusioni

L’AI sta rendendo sempre più impressionanti e potenti le applicazioni eseguite su dispositivi: foto, mappe, ricerche, comprensione di testo, traduzioni, etc. Qualche anno fa sarebbe stato improponibile eseguire localmente tutti questi calcoli: oggi non solo è possibile grazie alla maggiore potenza di calcolo ma è addirittura necessario per tutelare anche la privacy degli utenti.

Google ed Apple ci hanno lasciato a bocca aperta nelle loro demo e non vediamo l’ora di poter accedere a questi nuovi prodotti. Build, invece, ha mostrato come Microsoft sia interessata principalmente a offrire servizi sul cloud Azure allo scopo di realizzare non solo applicazioni AI enterprise ma anche low code. Sono quindi mancati annunci clamorosi che attirassero l’attenzione dei media ma sicuramente il numero di aziende che sfrutterà i nuovi servizi aumenterà notevolmente nei prossimi anni.

Infine Amazon, come suo solito, ha sottolineato la sua posizione da leader sul mercato come fornitore di servizi cloud grazie a prodotti come SageMaker.

In tutti gli eventi sono state presentate piattaforme di formazione, corsi online, tutorial, workshop e altri strumenti pensati per formare gli utenti, evidenziando così la necessità di democratizzare l’intelligenza artificiale e di uscire dal mito della figura misteriosa del Data Scientist di cui si è tanto parlato negli ultimi anni.

Nessuna rivoluzione in vista, ma uno sfruttamento sempre più intensivo della potenza di calcolo locale, che ci permetterà di aggiungere intelligenza alle nostre applicazioni sia nella cattura dell’input che nell’analisi dei dati.

Se siete curiosi di sapere come sfrutteremo le grandi potenzialità degli strumenti annunciati, continuate a seguirci!